Beeindruckend und creepy: Live-KI für die Ray-Ban Meta Smart Glasses

In anderen Sprachen lesen:

Seit dem Release der Ray-Ban-Brille im Jahr 2023 hat Meta ihre Fähigkeiten mit regelmäßigen Funktionsupdates weiter verbessert. Die neueste Firmware, Version 11, führt verbesserte KI-Features ein, darunter multimodale Live-KI-Funktionen, Echtzeit-Übersetzung und die Integration von Shazam.

Sprich natürlich mit der Meta-KI

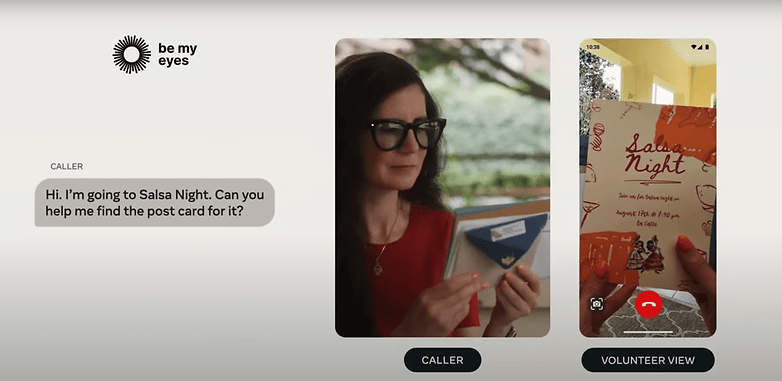

Mit der neuesten Version werden die multimodalen Fähigkeiten der Ray-Ban Meta Smart Glasses (Test) durch die Unterstützung von Live-Videos deutlich verbessert.

Mit der aktivierten Live-KI kann die Ray-Ban Meta Smart Glasses kontinuierlich die Umgebung erfassen und auf Anfragen reagieren, ohne dass ein Weckbefehl oder eine manuelle Aktivierung erforderlich ist. Zu den wichtigsten Funktionen gehören die Erkennung von Zutaten, um Rezepte vorzuschlagen, und die Bereitstellung von kontextbezogenen Informationen zu Objekten und Szenen im Sichtfeld.

Außerdem funktioniert diese Funktion nahtlos, während ihr telefoniert und mit der Ray-Ban-Brille verbunden seid, wie Meta im September demonstrierte.

Live-Übersetzung kommt auf die Ray-Ban Meta Smart Glasses

Der Assistent unterstützt auch natürliche Unterbrechungen, sodass Ihr nahtlos das Thema wechseln oder auf vorherige Anfragen aufbauen könnt. Dies baut auf Metas früherer "Look and Ask"-Funktion auf, bei der man den Assistenten für jede Frage aufrufen musste – eine Einschränkung, die nun entfällt.

Erinnert Ihr Euch an Googles Prototyp einer smarten Brille von vor zwei Jahren, die eine Echtzeit-Übersetzung versprach? Meta bringt jetzt eine ähnliche Funktion auf seine Smart Glasses.

- Nicht verpassen: Ray-Ban Meta Smart Glasses Headliner im Hands-On

Die Ray-Ban Meta Smart Glasses übersetzt gesprochene Sprachen automatisch ins Englische und spielt die Übersetzung über die Lautsprecher des Geräts ab oder zeigt sie in der Meta-App an. Zum Start werden die Sprachen Französisch, Italienisch und Spanisch unterstützt.

Fragt die Ray-Ban-Brille von Meta, welcher Song gerade läuft

Meta hat auch Shazam für die Erkennung von Songs integriert. Anders als bei der Live-KI und der Übersetzung muss die Meta-KI bei dieser Funktion jedoch manuell aufgeweckt werden. Die Nutzer:innen können dann den Assistenten bitten, Lieder zu erkennen, die im Hintergrund laufen.

Das Update mit den Funktionen ist derzeit über eine Warteliste verfügbar und wird zunächst in den USA und Kanada eingeführt, bevor es auf weitere Länder ausgedehnt wird. Meta hat jedoch nicht gesagt, wann wir diese Erweiterungen weltweit sehen werden.

Bessere KI-Funktionen, aber mehr Probleme mit dem Datenschutz?

Auch wenn diese KI-gestützten Funktionen zweifellos beeindruckend sind, werfen sie Fragen zum Datenschutz und zur Datenerfassung auf – Fragen, die in den letzten Jahren immer wieder Wearables wie die Ray-Ban Smart Glasses begleiteten.

Laut Meta werden Bilder, Texte und andere Daten, die vom Gerät erfasst werden, in der Cloud verarbeitet und zum Trainieren der KI-Modelle verwendet. Das solltet Ihr bedenken, bevor Ihr diese neuen Funktionen aktiviert.

Was denkt Ihr über die neuen KI-Tools der Ray-Ban Smart Glasses von Meta? Teilt uns Eure Meinung in den Kommentaren mit.

Quelle: Meta

Es gibt doch schon seit knapp 2 Jahren Alexa-Skills, die an die ChatGPT API andocken und damit die AI-Funktionalität auf die alten Alexas bringen. Der einzige Nachteil ist, dass dies nicht nativ implementiert ist und man erst eine Skill-App ansprechen muss. Meine Erfahrung ist, dass man solch einen Skill schnell nicht mehr missen will.

Einmalig: »Alexa, aktiviere Skill Smart Guide«

Anschließend: »Alexa, Smart Guide«

Und schon kann man alle Fragen usw. stellen, so wie man es von ChatGPT im Browser gewohnt ist.

Findet man im Skill-Store in der Kategorie:

Alexa Skills -> Produktivität -> Organizer & Helfer