Samsung dementiert Fake-Vorwürfe der Space-Zoom-Funktion

Wie bei früheren Ultra-Modellen der Samsung-Galaxy-S-Serie ist das Galaxy S23 Ultra in der Lage, mit bis zu 200 Zoomstufen und entsprechenden Softwareverbesserungen recht beeindruckende Mondaufnahmen zu machen. Aber Anfang dieser Woche wurde in einem Reddit-Post behauptet, dass Samsung diese Mondaufnahmen fälschen würde, indem es nicht vorhandene Details hinzugefügt. Nun bezieht Samsung Stellung und veröffentlichte ein Statement zum Fake-Vorwurf.

Samsung nimmt Stellung zu den Fake-Vorwürfen

Samsung führte die sogenannte "Space Zoom"-Funktion bereits mit dem Galaxy S20 Ultra ein. Sie ermöglicht einen erweiterten Digitalzoom mit bis zu 100-facher Vergrößerung, um ein recht beeindruckendes Foto des Mondes zu erstellen. Beim Samsung Galaxy S23 Ultra wurde er mit einem größeren 200-MP-Kamerasensor und einer bis zu 200-fachen Vergrößerung verbessert.

- Verpasst nicht: Anleitung zur Astrofotografie des Galaxy S23

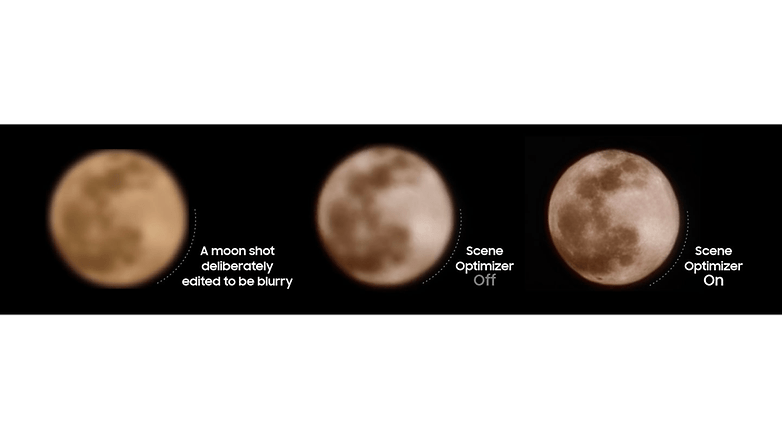

In einem viralen Reddit-Posting wird jedoch behauptet, dass diese Bilder nicht die tatsächlichen Bilder sind, die das Gerät aufgenommen hat. Vielmehr behauptet die Quelle, dass Samsung Texturen zum Mond hinzufügt und das Originalmaterial so verbessert. Schließlich wären die originalen Aufnahmen unscharf, final aber detailliert und scharf. Samsung würde eine KI mit Informationen füttern, wo genau die Details überlagert werden sollen, sodass die Mondbilder am Ende als gefälscht gelten würden.

In einer Pressemitteilung mit einer detaillierten Anleitung erklärt Samsung, dass es verschiedene Algorithmen einsetzt, um die Mondbilder zu bearbeiten, die von leistungsfähigen Galaxy-Kamerahandys wie dem Galaxy S23 Ultra (Test) aufgenommen werden.

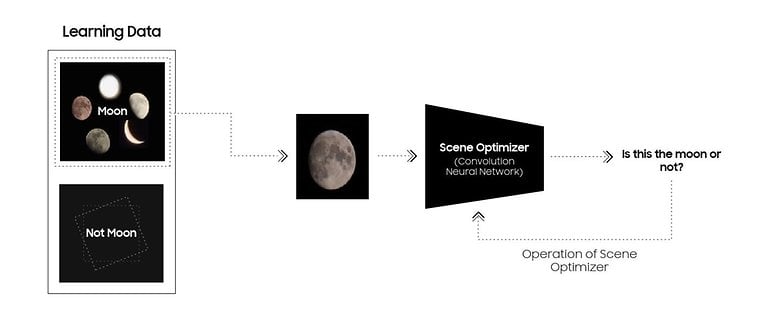

Dementsprechend wird zuerst der "Scene Optimizer"aktiviert, um das Mondfoto zu verfeinern. Dieser Schritt erfordert, dass der Mond zuerst erkannt wird, bevor dieser Effekt angewendet wird. Der zweite Schritt ist der "Super Resolution"-Modus, um mehrere Aufnahmen des Mondes mit 25-fachem Zoom oder höher zu machen und diese Mehrfachaufnahmen schließlich zu einem Bild zusammenzusetzen.

Am interessantesten ist vielleicht, wie Samsung mithilfe eines KI-Tiefenlernmodells erkennt, ob es sich bei dem Objekt um einen Mond handelt oder nicht. Nach Angaben von Samsung wurde das neuronale Netzwerk mit Bildern des Mondes (möglicherweise in Tausenden von Exemplaren) in verschiedenen Formen und Phasen trainiert. Samsung fügt hinzu, dass bei dem "Scene Optimizer" auch KI-basiertes "Deep Learning" eingesetzt wird, um Rauschen zu reduzieren und das Endresultat zu schärfen.

Gleichzeitig wird angegeben, dass es Fälle gibt, in denen der Mond nicht erkannt wird, wenn er von Wolken verdeckt wird oder der Himmelskörper nicht gut beleuchtet ist, wie z. B. in Neumondphasen. Der Samsung "Scene Optimizer" kann also nur dann optimal arbeiten, wenn der Mond auf smarte Weise erkannt wird.

In der dritten Stufe schließlich steuert die Kamera kontinuierlich die Schärfe und die Helligkeit des gesamten Bildes, um eine klarere Sicht auf den Mond zu ermöglichen. Ersteres wird durch die Kombination der optischen und digitalen Bildstabilisierung des Telefons ermöglicht.

Auch wenn Samsung die angebliche Behauptung nicht direkt entkräftet: Glaubt Ihr, dass die auf den Galaxy-Smartphones bei der Aufnahme von Mondbildern verwendeten Methoden im Rahmen der Standard-Smartphone-Computerfotografie liegen? Oder sind das auch für Euch Fakes? Sagt uns Eure Meinung.

Quelle: Samsung

Glaube schon das es Ki-Bearbeitet wird. Und nicht nur bei denen. Ich selber habe ein Google P7p. Damit habe ich den Mond mit 30x Zoom fotografiert. Auf dem Foto kann ich wunderbar Krater etc. erkennen, wodurch ich auch hierbei an ein bearbeitetes Foto glaube.

Ich glaube Samsung nicht. Soweit ich gelesen habe, hat jemand ein verpixeltes Bild des Mondes von einem Monitor abfotografiert und bekam dennoch ein schönes Foto von unserem Trabanten. Also hat die Kamera weit mehr "gesehen", als tatsächlich da war. Und damit ein Fake, oder Neudeutsch Fälschung.

"Samsung fügt hinzu, dass bei dem "Scene Optimizer" auch KI-basiertes "Deep Learning" eingesetzt wird, um Rauschen zu reduzieren und das Endresultat zu schärfen."

Steht ja auch da. Macht ja auch Sinn, ein scharfes Foto bekommst du ohne Tricksereien nicht hin.

Das ist richtig. Aber wenn ich was Verpixeltes fotografiere und bekomme dann aber ein schönes Foto mit vielen Details, ist es nicht das, was ich fotografiert habe. Es ist ein vorgefertigtes, abgespeichertes Bild.

Das stimmt so nicht ganz.

Schau dir mal das YT Video von Mrwhosetheboss dazu an. Er hat ein 'mondfremdes' Bildschnipsel in den Mond geshopt um zu sehen, wie die Kamera damit umgeht. Und tatsächlich hat die auf den Mond trainierte KI den Schnipsel in eine mondtypische Struktur umgewandelt, weil sie dachte, dass es Teil des Planeten sei. Es steckt also kein vorgefertigtes Mond-Bild dahinter.

Für mich sind doch heutzutage alle Bilder die aus dem Handy kommen "gefaked". Wenn ich mir mein 13PM angesehe dann lief auch eine Bearbeitungen als ich Bilder öffnete. Die Leute wollen halt immer nur "die perfekten Bilder" da muss man mit KI nachhelfen. Wenn man das nicht will soll man halt alles auf manuell stellen

Ich finde die ganze Aufregung etwas überzogen, schließlich versucht Samsung ja nur, das Nutzererlebnis zu verbessern und solange man das abstellen kann ist doch auch alles in Ordnung. Wo steht denn geschrieben, dass Fotos zwingend die Realität abbilden müssen? Spätestens mit den ganzen Filtern der sozialen Medien ist das doch eh hinfällig. Die Leute wollen einfach schöne Fotos haben und da bietet Samsung Unterstützung. Wers nicht möchte, schaltet es halt ab.

Ich find's irgendwie einfach nur noch zum Lachen. Vor allem ist das jetzt wahrscheinlich doof für all die, die auf TikTok und sonst wo das Ding ständig mit dem iPhone und dann mit "haha schau mal, das iPhone kann das nicht" ankommen ?

Generell wäre es mir bei allen Herstellern einfach lieber, wenn man dieses ganze, Extreme Bearbeiten ausschalten könnte. Gerade bei den heutigen, großen Sensoren wäre das alles nicht nötig.

Du kannst die 'Szenenoptimierung' dauerhaft ausschalten und hast dann den undefinierten weißen Fleck als Mond.

Bei HDR und Co wird's schwieriger mit dem Ausschalten. Ich persönlich bin eher der Point & Shoot Typ und schätze die meisten Software Tricks der Smartphones.

Naja, ist ja nur eine der Sachen die iPhones nicht können. Bei sowas wie Multitasking oder guter Gestensteuerung sieht es beim iPhone mau aus ^^'

Und hey, so stark ranzuzoomen geht beim iPhone ebenfalls nicht, selbst ohne Szene Optimizer geht so ein Zoom nicht, geschweige denn das, was zwischen dem optischen 10-fach Zoom und dem 100-fach Zoom liegt ;)