Exmor, Isocell & Co: Darum ist der Bildsensor im Smartphone so wichtig!

Während die Smartphone-Hersteller das Pixelrennen gerade eifrig in dreistellige Megapixelzahlen schrauben und irgendwelche Phantasie-Zoomstufen auf ihre Telefone schreiben, bleibt eine viel wichtigere Kamera-Eigenschaft im Halbdunkel: die Sensorgröße. Warum diese so entscheidend ist für die Bildqualität, lest Ihr hier.

Inhalt:

- Sensorgröße in Zoll: Von Analogröhren zu CMOS-Chips

- Effektive Sensorfläche: Viel hilft viel

- Bayer-Maske & Co.: Jetzt wird's bunt

- Kamera-Software: Algorithmus ist alles

- Autofokus: PDAF, 2x2 OCL & Co.

Sensorgröße in Zoll: Von Analogröhren zu CMOS-Chips

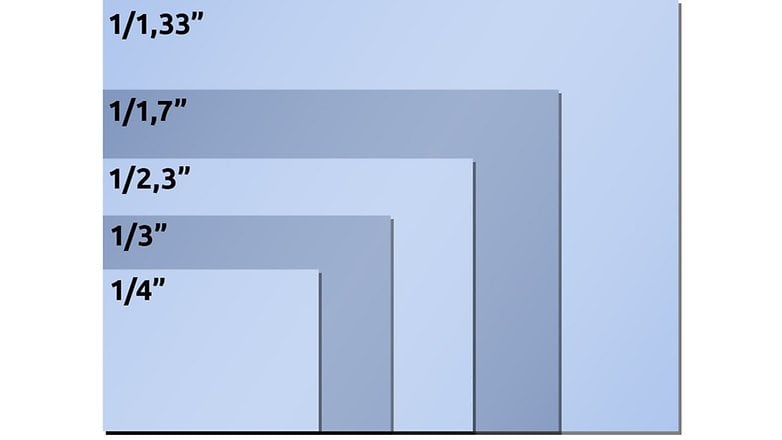

Zum Start etwas historischen Hintergrund: In den Datenblättern von Kamera-Smartphones findet sich die Sensorgröße immer in der reichlich schrägen Angabe 1/xyz Zoll, also beispielsweise 1/1,72 Zoll oder 1/2 Zoll. Leider entspricht diese Größe rein gar nicht der tatsächlichen Größe Eures Smartphone-Sensors.

Gucken wir ins Datenblatt des IMX586: Das halbe Zoll dieses 1/2-Zoll-Sensors entspräche ja eigentlich 1,27 Zentimetern. Die reale Größe des Sony IMX586 hat damit jedoch nicht viel zu tun. Multiplizieren wir die 0,8 Mikron Pixelgröße mit der horizontalen Auflösung von 8000 Pixeln, kommen wir nur auf 6,4 Millimeter, also gerade mal auf die Hälfte. Bemühen wir erst die Horizontale und dann Pythagoras für die Diagonale, kommen wir auf 8,0 Millimeter. Auch das reicht nicht einmal annähernd.

Und hier ist der Knackpunkt: Die Zollangaben wurden vor etwa einem halben Jahrhundert eingeführt, als Videokameras noch auf Vakuumröhren als Bildwandler setzten. Die Marketing-Abteilungen behalten das damalige ungefähre Verhältnis aus lichtempfindlicher Fläche zu Röhrendurchmesser bis heute so eifrig bei, als würden sie auch die Penisverlängerungsmails in meinem Spam-Ordner schreiben. Und so heißt ein CMOS-Chip mit einer Diagonale von 0,31 Zoll heutzutage 1/2-Zoll-Sensor.

Wenn Ihr die tatsächliche Größe eines Bildsensors wissen möchtet, hilft entweder ein Blick ins Datenblatt des Herstellers oder die ausführliche Wikipedia-Seite zu Bildsensorgrößen weiter. Oder Ihr macht es wie im obigen Beispiel und multipliziert die Pixelgröße mit der horizontalen beziehungsweise vertikalen Auflösung.

Effektive Sensorfläche: Viel hilft viel

Warum ist die Sensorgröße nun so wichtig? Stellt Euch das durchs Objektiv auf den Sensor einfallende Licht als Regen vor, der vom Himmel prasselt. Ihr habt nun eine Zehntelsekunde Zeit, um die aktuell herabfallende Wassermenge abzuschätzen.

- Mit einem Schnapsglas wird euch das relativ schwer fallen. In der Zehntelsekunde fallen bei starkem Regen vielleicht ein paar wenige Tropfen ins Glas – bei wenig Regen oder mit etwas Pech womöglich auch gar keiner. Eure Abschätzung wird in jedem Fall sehr ungenau.

- Nun stellt Euch vor, Ihr habt ein Planschbecken für die gleiche Aufgabe. Damit fangt Ihr locker ein paar Hundert bis Tausend Regentropfen ein, und könnt aufgrund der Fläche präzise auf die Regenmenge schließen.

Genau so wie mit Schnapsglas, Planschbecken und Regen verhält es sich mit Sensorgrößen und viel beziehungsweise wenig Licht. Je dunkler es ist, desto weniger Photonen fangen die Lichtwandler ein – und desto ungenauer ist das Messergebnis. Diese Ungenauigkeiten äußern sich hinterher in Fehlern wie Bildrauschen, kaputten Farben et cetera.

Zugegeben: Der Unterschied bei den Smartphone-Bildsensoren ist nicht ganz so groß wie der zwischen einem Schnapsglas und einem Planschbecken. Aber der oben erwähnte Sony IMX586 in der Telekamera des Samsung Galaxy S20 Ultra ist flächenmäßig etwa viermal größer als der 1/4,4-Zoll-Sensor in der Telekamera des Xiaomi Mi Note 10.

Über den Sinn und Unsinn von 100x-Zooms sowie über optischen Zoom und Brennweiten in Smartphones haben wir an anderer Stelle bereits einen detaillierten Artikel für Euch veröffentlicht.

Bayer-Maske & Co.: Jetzt wird's bunt

Geht bitte noch einmal zurück zu unserer Wasser-Analogie von oben. Wenn wir nun 4000 mal 3000 Eimer auf einer Wiese aufstellen würden, könnten wir mit einer Auflösung von 12 Megapixeln die einfallende Regenmenge bestimmen und vermutlich irgendeine Art Bild von der Wassersättigung der überfliegenden Regenwolke schießen.

Würde ein Bildsensor mit 12 Megapixeln nun allerdings mit seinen 4000 mal 3000 Photonenfallen die Lichtmenge erfassen, wäre das resultierende Foto schwarzweiß – denn wir messen ja nur die absolute Lichtmenge. Die Farben können wir ebensowenig unterscheiden wie ein Eimer die Größe der einfallenden Regentropfen. Wie wird aus dem Schwarzweiß- nun ein Farbfoto?

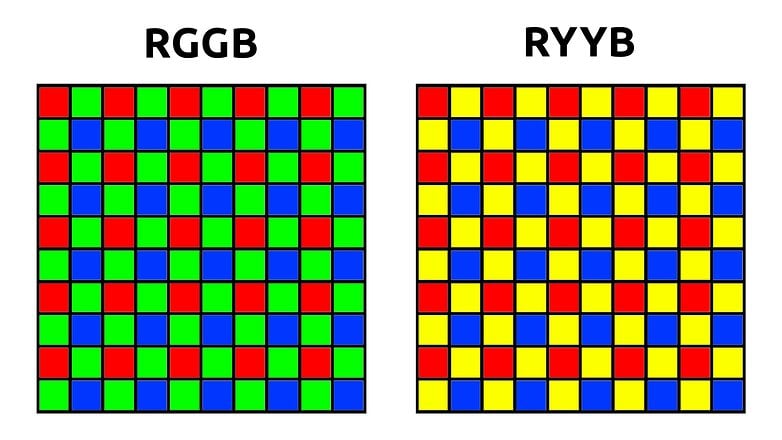

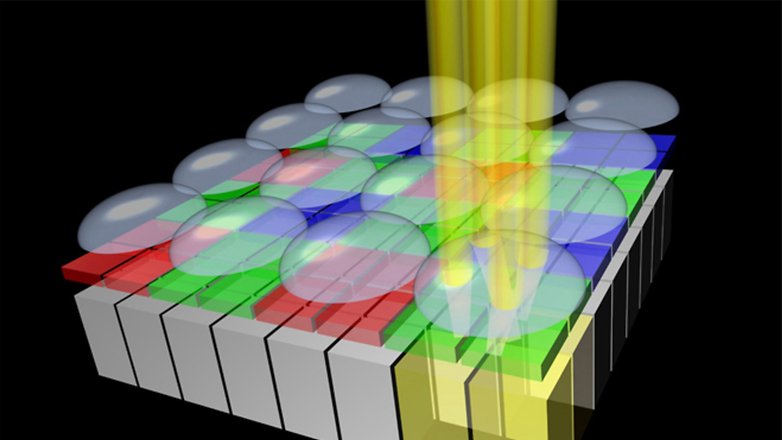

Der Trick besteht darin, eine Farbmaske über dem Sensor anzubringen, die sogenannte Bayer-Matrix. Diese sorgt dafür, dass an den Bildpunkten entweder nur rotes, blaues oder grünes Licht ankommt. Bei der klassischen Bayer-Matrix mit RGGB-Layout hat ein 12-Megapixel-Sensor dann sechs Millionen grüne sowie je drei Millionen rote und blaue Bildpunkte.

Um aus diesen Daten anschließend ein Bild mit zwölf Millionen RGB-Pixeln zu erzeugen, nimmt sich die Bildverarbeitung beim sogenannten Demosaicing zunächst typischerweise die grünen Pixel vor. Anhand der umliegenden roten und blauen Bildpunkte errechnet der Algorithmus dann – ganz stark vereinfacht – für diese einen RGB-Wert. In der Praxis sind die Demosaicing-Algorithmen deutlich intelligenter, um beispielsweise Farbsäume an scharfen Kanten zu vermeiden. Anschließend folgt das gleiche Spiel mit den roten und blauen Pixeln, und im internen Speicher Eures Smartphones landet ein buntes Foto.

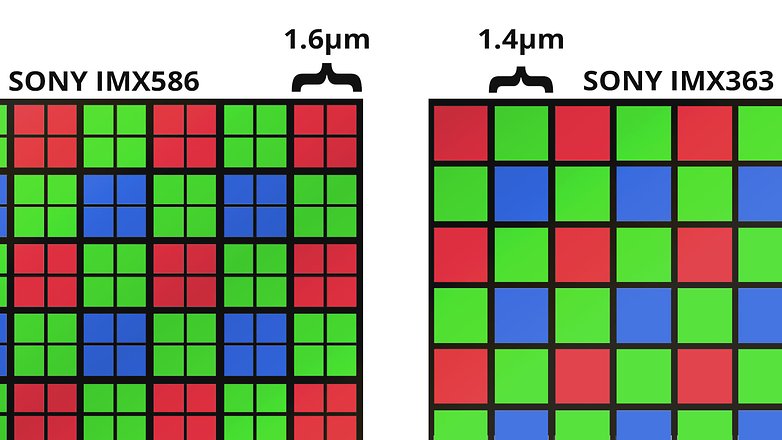

Quad Bayer und Tetracell

Ob 48, 64 oder 108 Megapixel: Die meisten der aktuell extrem hochauflösenden Sensoren in Smartphones haben eines gemein: Während der Sensor selbst tatsächlich 108 Millionen Wassereimer respektive Lichtsensoren hat, löst die darüberliegende Bayer-Maske um den Faktor vier geringer auf. Unter jedem Farbfilter sitzen also jeweils vier Pixel.

Das ist im Datenblatt natürlich wahnsinnig toll. Ein 48-Megapixel-Sensor! 108 Megapixel!! Megakrass viele Details. Und wenn's mal dunkel ist, dann lassen sich die winzigen Pixel zu großen Superpixeln zusammenfassen und liefern tolle Nachtaufnahmen.

Paradoxerweise bieten gerade viele günstigere Smartphones dann jedoch gar nicht die Möglichkeit, 48-Megapixel-Fotos aufzunehmen – oder liefern hier im direkten Vergleich mit dem 12-Megapixel-Modus sogar eine schlechtere Bildqualität. In allen mir bekannten Fällen sind die Smartphones beim Fotografieren mit maximaler Auflösung auch so viel langsamer, dass sich das mäßige Qualitätsplus nicht lohnt – zumal 12, 16 oder 27 Megapixel für den Alltagsgebrauch völlig ausreichen und den Speicher nicht so schnell vollstopfen.

Die meist vorgeschobene Marketingbotschaft mit den zig Megapixeln mag zu ignorieren sein. Doch in der Praxis sind die hochauflösenden Sensoren tatsächlich größer – und davon profitiert die Bildqualität spürbar.

Huaweis SuperSpectrum-Sensor: das Gleiche in gelb

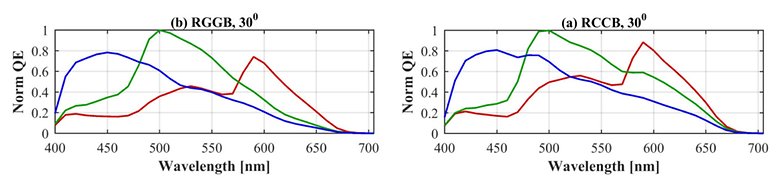

Es gibt auch ein paar Abkömmlinge der Bayer-Matrix. Huawei als prominentestes Beispiel setzt bei einigen Sensoren auf eine sogenannte RYYB-Matrix (siehe Grafik oben), bei der das Absorptionsspektrum der grünen Pixel ins Gelbe verschoben ist. Das hat – zumindest auf dem Papier – den Vorteil, dass mehr Licht absorbiert wird und im Dunkeln mehr Photonen auf dem Sensor ankommen.

Dafür sind jedoch die vom Sensor gemessenen Wellenlängen nicht mehr so gleichmäßig im Spektrum verteilt und so klar voneinander getrennt wie bei einem RGGB-Sensor. Um eine akkurate Farbwiedergabe beizubehalten, steigen die Anforderungen an die Algorithmen, die hinterher die RGB-Farbwerte interpolieren müssen.

Welcher Ansatz unterm Strich die besseren Fotos macht, lässt sich nicht vorhersagen. Hier sind es dann die Praxis- und Labortests, die der einen oder anderen Technologie recht geben.

Kamera-Software: Der Algorithmus macht die Musik

Zum Schluss möchte ich zu den gerade angesprochenen Algorithmen noch ein paar Worte verlieren. Gerade im Zeitalter der Computational Photography verschwimmt der Begriff der Fotografie. Ist ein aus zwölf Einzelfotos zusammengesetztes Bild wirklich noch eine Fotografie im ursprünglichen Sinne?

Fest steht, dass der Einfluss der Bildverarbeitungsalgorithmen viel größer ist als das letzte Quäntchen Sensorfläche. Ja, ein flächenmäßiger Unterschied um den Faktor zwei macht einen großen Unterschied. Aber ein guter Algorithmus macht ebenfalls viel wett. Der Sensor-Weltmarktführer Sony ist ein gutes Beispiel dafür. Obwohl die meisten Bildsensoren (zumindest technologisch) aus Japan kommen, hinken die Xperia-Smartphones in Sachen Bildqualität der Konkurrenz stets hinterher. Japan kann Hardware, aber bei der Software sind die anderen weiter.

Und an dieser Stelle nochmal ein Hinweis zur ISO-Empfindlichkeit, die ebenfalls mal einen eigenen Artikel verdient hat: Lasst Euch bitte niemals von ISO-Zahlen beeindrucken. Bildsensoren haben nämlich in fast allen Fällen* eine einzige native ISO-Empfindlichkeit, die sich äußerst äußerst selten in Datenblättern findet. Jene ISO-Werte, die Fotograf oder Kameraautomatik beim eigentlichen Fotografieren einstellen, entsprechen eher einem Gain – also einem "Helligkeitsregler". Wie "lang" die Skala bei diesem Helligkeitsregler ist, lässt sich quasi frei festlegen. Einen Wert wie ISO 409.600 ins Datenblatt zu schreiben ist daher so sinnvoll wie bei einem VW Golf... naja, lassen wir das.

*Es gibt im Kamera-Markt tatsächlich ein paar wenige Dual-ISO-Sensoren mit zwei nativen Empfindlichkeiten, beispielsweise der Sony IMX689 im Oppo Find X2 Pro, zumindest sagt das Oppo. Ansonsten wird man bei dem Thema eher bei Profi-Kameras fündig wie der BMPCC 6K.

Autofokus: PDAF, 2x2 OCL & Co.

Ein kleiner Exkurs noch zum Schluss, der direkt mit dem Bildsensor zusammenhängt: das Thema Autofokus. Früher haben Smartphones den korrekten Fokus über den Kontrast-Autofokus bestimmt. Dabei handelt es sich um eine langsame und rechenintensive Kantenerkennung, die Ihr bestimmt von dem lästigen Fokus-Pumpen her kennt.

Die meisten Bildsensoren haben inzwischen einen sogenannten Phasenvergleichs-Autofokus integriert, auch bekannt als PDAF. Bei diesem sind auf dem Sensor spezielle Autofokus-Pixel verbaut, die in zwei Hälften geteilt die Phasen des einfallenden Lichts vergleichen und anhand dessen die Entfernung zum Motiv berechnen können. Der Fokus-Motor der Kamera fährt dann zielstrebig und ohne Pumpen an die richtige Position. Der Nachteil dieser Technologie besteht darin, dass der Bildsensor an diesen Punkten "blind" ist – und diese blinden Fokuspixel betreffen je nach Sensor schon einmal drei Prozent der Fläche.

Nur zur Erinnerung: Weniger Fläche, weniger Licht/Wasser, weniger Bildqualität. Zudem die Algorithmen diese Fehlstellen auch noch wegretuschieren müssen wie Euer Gehirn den "blinden Fleck".

Es gibt jedoch einen eleganteren Ansatz, der keine Pixel unbrauchbar macht. Dabei werden die ohnehin auf dem Sensor vorhandenen Mikrolinsen stellenweise über mehrere Pixel verteilt. Sony beispielsweise nennt das bei seinen Sensoren dann 2x2 OCL beziehungsweise 2x1 OCL, je nachdem, ob die Mikrolinsen nun vier oder zwei Pixel zusammenfassen.

Dem Autofokus widmen wir demnächst noch einen eigenen, ausführlicheren Artikel. Worauf achtet Ihr bei der Kamera, wenn Ihr Euch ein neues Smartphone kauft? Und zu welchen Themen rund um die Handy-Fotografie würdet Ihr gerne mehr lesen? Ich freue mich auf Eure Kommentare!

Weitere Artikel rund ums Thema Smartphone-Kameras und Fotografie:

Wenn ich das richtig mitbekommen habe, ist der Unterschied in der Bildqualität insgesamt nicht allzu groß zwischen einem Samsung S20 Ultra und einem "normalen" S20. Aber es soll im Detail Unterschiede geben, etwa bei der Schärfentiefe.

Vielen Dank für den informativen Artikel - gerne mehr davon!

Sehr interessanter Artikel. Obwohl ich als Voll-Laie stellenweise ein wenig überfordert war. Aber dennoch sehr informativ. Jetzt verstehe ich wenigstens teilweise, was hinter der Linse meiner Smartphone-Kamera passiert. Kann ich bei nächster Gelegenheit mit angeben.:-)

Hätte ich nicht treffender formulieren können. Mir sind diese ganzen Fotofachbegriffe immer böhmische Bahnhöfe gewesen, jetzt verstehe ich immerhin etwas mehr!

Interessantes Titelfoto. Das neue Galaxy S30?

Gut formulierter Bericht ?

-

Admin

-

Staff

17.06.2020 Link zum KommentarWer weiß, vielleicht ist das S30 auch was für Tryptophobiker :p Das Foto zeigt allerdings eine Light L16.

Vielen Dank @Stefan.

Sehr verständlich, sehr gut geschrieben ??

Ich würde nicht sagen, dass die Pixelgröße relativ nichtssagend ist. Im Gegenteil. Viele kleine Pixel machen den Vorteil eines größeren Sensor sehr schnell komplett zunichte.

So gut wie jedes Mittelklasse-Smartphone hat heute 48 oder 64MP - mit entsprechender Sensorgröße, also bei 48MP so gut wie immer 1/2". Das ist deutlich größer, als die Sensoren in Flaggschiffen von vor gerade mal 1-2 Jahren und trotzdem ist die Bildqualität quasi ausnahmslos Welten schlechter.

Genauso beim Vergleich zu großen DSLRs. Wäre die Pixelgröße "relativ egal", würden APS-C-Sensoren doch längst mit 500MP oder sonstigem auflösen. Und bei DSLRs spielt auch eher weniger ein super krasser Algorithmus mit rein, welchen man den Flaggschiffen mit kleineren Sensoren von vor 1-2 Jahren zu Gute halten könnte.

Gerade in der Mittelklasse hat sich die Bildqualität trotz der wesentlich größeren Sensoren kaum bis gar nicht verbessert - eben weil die vielen winzigen Pixel die Vorteile zunichte machen.

Am Ende kommt es immer drauf an, wie viel Licht jedes einzelne Pixel aufnehmen kann, nicht nur der Sensor insgesamt. Ist wie bei einem Fliegengitter: je feinmaschiger es ist (also je kleiner die "Pixel") desto schwerer kann man hindurch sehen und desto dunkler macht es das Sichtfeld beim Durchschauen auch.

-

Admin

-

Staff

17.06.2020 Link zum KommentarHi Tim,

jaa, einen kleinen Effekt mag es schon geben, aber ich glaube, dass der im Vergleich zu anderen Parametern nicht so ins Gewicht fällt. Seit den „gapless microlenses“ bei Kamera-Sensoren gibt's keinen Fliegengitter-Effekt mehr, weil die Mikrolinsen über den einzelnen Pixeln dafür sorgen, dass die Fläche quasi voll ausgenutzt wird. Von der aufgefangenen Lichtmenge her ist es deswegen egal, ob nun 10 oder 100 Megapixel auf dem Sensor sind.

Die vielen Megapixel haben aber durchaus auch Vorteile. Wie im Artikel geschrieben kann man mit 2x2-OCLs alle Pixel als PD-Kreuzsensoren nutzen, was für den Autofokus wirklich krass ist. Um mit dem Trick keine Farbauflösung zu opfern, braucht man aber eben unter einem RGGB-Sensor mit 3/6/3 Millionen Farbfiltern schon mindestens 48 Megapixel. Ein 12-Megapixel-2x2-OCL-Sensor hätte ja am Ende nur noch 3 Megapixel Farbauflösung, und die ja durch Bayer-Pattern auch nur interpoliert.

Das IMHO größte Problem mit steigender Megapixel-Zahl ist dann eher die Bildverarbeitung, weil die Datenmenge einfach echt gigantisch wird. Das spürt man ja auch bei den aktuellen 100-Megapixel-Böllern, da macht das Fotografieren einfach wenig Spaß – da kann man auch gleich ein Stillleben malen :D Und wenn die Kundschaft bei einer DSLR zehn Bilder pro Sekunde erwartet, dann kann man selbst da mit den fetten dedizierten Bildprozessoren keine 500 Megapixel auf den Sensor packen. Zumal in dem Bereich Fotografen wie Hersteller das Selbstbewusstsein haben, dass man so viele Pixel gar nicht braucht – der Platzbedarf bei RAWs wächst ja quasi ins Unendliche.

Dass die Bildqualität aktueller Smartphones quasi ausnahmslos um Welten schlechter ist, würde ich so nicht unterschreiben. Was bei aktuellen Smartphones durchaus vorkommt, sind Probleme mit den Algorithmen, die vermutlich mit den neuen Pixelstrukturen und den extremen Pixelzahlen nicht so gut zurechtkommen. Xiaomi hat beim Mi Note 10 aber z. B. inzwischen die anfangs recht fiesen Bildartefakte gut in den Griff bekommen.

Vielleicht sollten wir mal Bildqualität-Vergleiche zwischen verschiedenen Smartphone-Generationen machen – wie groß ist der Unterschied von S8 zu S9 zu S10 zu S20? Wäre sicher interessant ;-)

Schöne Grüße

Stefan