Apple fügt "Live Speech" und KI-basierte Spracherzeugung in iOS 17 ein

Apple stellt jetzt mehrere Funktionen von iOS 17 vor, die die Sprach-, Seh- und kognitive Barrierefreiheit auf iPhones und iPads verbessern sollen. Zu den Verbesserungen gehören Text-to-Speech und KI-basierte persönliche Stimmerzeugung, die zusammen mit dem "Assistive Access" noch in diesem Jahr eingeführt werden sollen.

iOS 17: Live Speech, Spracherzeugung und vieles mehr!

Apple baut die bestehenden Funktionen für Barrierefreiheit weiter aus und führt gleichzeitig neue Funktionen ein. Sowohl "Live Speech" als auch "Assistive Access" sind völlig neue Funktionen, während "Point and Speak" ein Update der in Apple integrierten App Magnifier ist, die letztes Jahr mit iOS 16 auch eine Tür-Erkennung erhielt.

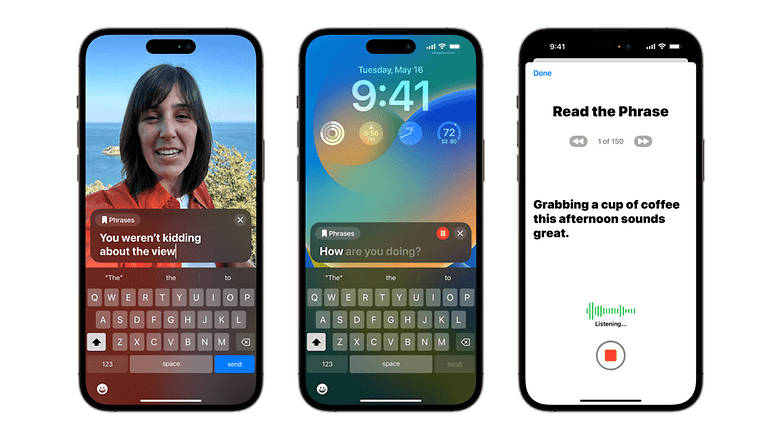

"Live Speech" ist die Version des iPhone-Herstellers von Text-to-Speech für Menschen, die nicht sprechen können, aber in FaceTime und in reguläre Telefonate integriert ist. Laut Apple können Nutzer:innen einen Text eingeben und die Funktion liest ihn der Person oder Gruppe, mit der sie telefonieren, vor. Apple gibt bekannt, dass die Funktion auf iPhones, iPads, Macs und MacBooks verfügbar sein wird.

Die andere sprachbezogene Funktion ist "Personal Voice", die auf dem maschinellen Lernen einer künstlichen Intelligenz basiert. Sie ermöglicht es den Nutzern, eine Stimme zu erzeugen oder zu synthetisieren, indem sie 15 Minuten lang aufgefordert werden, Texte zu lesen. Das hilft denjenigen, die aufgrund von Krankheiten wie ALS oder amyotropher Lateralsklerose ihre Stimme verlieren könnten. Die Technologie, die dahintersteckt, ähnelt der KI-Stimmenerzeugung von Amazon, die letztes Jahr angekündigt wurde.

"Assistive Access" vereinfacht die Nutzung von Apple Apps

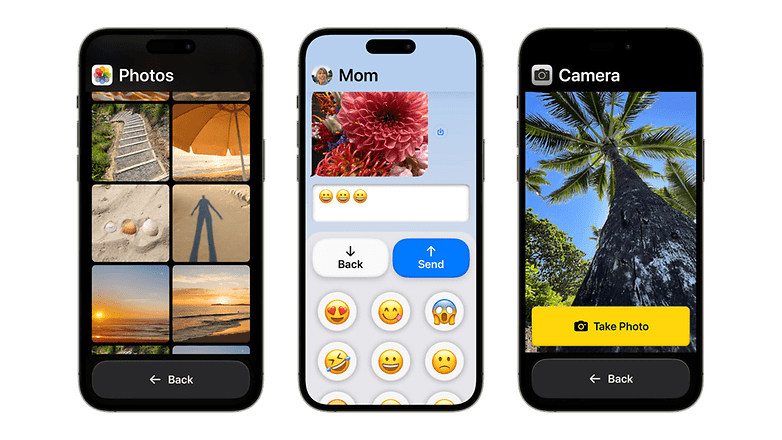

Der neue "Assistive Access" von Apple ermöglicht ein individuelles App-Erlebnis. Anstatt die Bedienelemente und Eingabemöglichkeiten von Apps zu erweitern, vereinfacht die Funktion die Nutzung dieser Apps für Senioren und Menschen mit kognitiven und visuellen Einschränkungen, indem sie vergrößerte Schaltflächen und Texte anzeigt. Es unterstützt Anwendungen wie die Hauptkamera, Nachrichten und Telefon sowie Apple Music und Fotos.

Die Lupe bekommt "Point and Speak"

Zusätzlich zur Erkennung von Personen und Türen sowie dem Vorlesen von Bildbeschreibungen kann die Lupe auf iPhones jetzt mehr Objekte über "Point and Speak" identifizieren, was mehr sehbehinderten Menschen helfen sollte, sich zurechtzufinden. Es funktioniert mit kurzen Beschriftungen, die auf Geräten zu finden sind. Zum Beispiel kann ein Nutzer auf eine Taste an einer Mikrowelle zeigen und die App liest den Text vor.

Es gibt auch Aktualisierungen und zusätzliche Funktionen in Bezug auf die Barrierefreiheit. Für Menschen mit motorischen Behinderungen verwandelt Apples "Switch Control" einen Schalter in einen virtuellen Game-Controller. Außerdem sagte Apple, dass Hörgerätezubehör für iPhones jetzt auch mit Mac-Geräten kompatibel sein wird. Sowohl die Sprachsteuerung als auch die Sprachausgabe über Siri erhalten phonetische Vorschläge bzw. Geschwindigkeitsanpassungen.

Apple hat noch nicht bestätigt, ob alle diese Verbesserungen mit iOS 17 oder separat als kleines Update in der nächsten Softwareversion eingeführt werden.

Wir würden gern von Euch wissen, welche Funktionen Ihr am hilfreichsten empfindet? Schreibt uns gern Eure Meinung zu dem Thema in die Kommentare.

Quelle: Apple