Google „Look to Speak“: Wenn Augen das Sprechen lernen

Mit einer neuen Android-App will Google Menschen mit motorischen und sprachlichen Beeinträchtigungen dabei helfen, mit anderen Menschen zu kommunizieren. Der Clou: Hierfür benötigt man nur ein Android-Smartphone ohne Zubehör.

Bedienungshilfen in aktuellen Smartphones oder Tablets machen es vielen Menschen leichter, ihren Alltag zu leben. Im aktuellen Beispiel demonstriert Google mit „Look to Speak“, wie dies bei motorischen und sprachlichen Beeinträchtigungen aussehen könnte.

Richard Cave, Logopäde bei Google, beschreibt in der Mitteilung, wie eine kleine Gruppe des Unternehmens mit den Fähigkeiten aktueller Smartphones experimentiert hat. Die „Look to Speak“ getaufte App erlaubt es Nutzern mit Hilfe ihrer Augen vordefinierte Sätze auszuwählen, die dann vom Handy ausgesprochen werden. Die App steht im Play Store zum Download parat und ist mit Android 9.0 oder neuer kompatibel. Geräte mit Android One sind ebenfalls dabei.

„Look to Speak“: Sprachsteuerung mit dem Auge

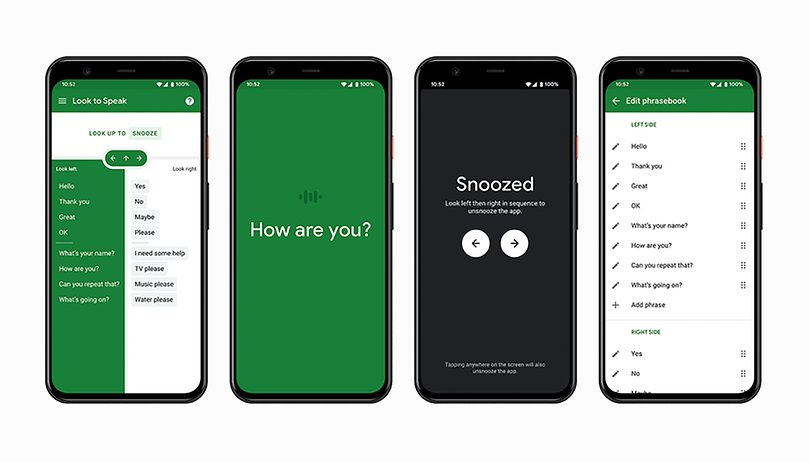

Die Sprachsteuerung gelingt dabei allein durch Bewegungen der Augen. Die Oberfläche der App ist in drei Bereiche geteilt. Je nachdem, ob man seine Augen nach links oder rechts bewegt, werden entsprechende Satzgruppen ausgewählt, die nach und nach verfeinert werden, bis man die gewünschte Phrase erreicht hat. Ein Blick nach oben erlaubt den Sprung zum Anfang der Auswahl.

Google erlaubt es dem Nutzer, die Sätze nach Belieben anzupassen, sodass man sie den persönlichen Anforderungen genauer anpassen kann. Diese Personalisierung sowie das Feintuning der Augenerkennung sind jedoch nicht über die eigentliche Augensteuerung erreichbar. Hier nutzt Google weiterhin eine traditionelle Smartphone-Steuerung.

Google experimentiert mit „Start with One“

„Look to Speak“ ist nur ein Teil von Googles „Start with One“-Initiative, welche wiederum zu „Experiments with Google“ gehört. Diese Projekte beginnen – wie der Name schon sagt – damit, dass sie zunächst nur einer Person helfen und erst später einer größeren Zielgruppe zugute kommen könnten. Eine dieser Anwendungen ist die „Teachable Machine“. Diese erlaubt das Trainieren eines Machine-Learning-Modells über ein Web-Interface, ohne dass man Programmieren können muss.

Richard Cave sagte, dass es faszinierend war zu beobachten, wie Look to Speak in Situationen genutzt werden konnte, in der andere bisherige Lösungen nicht verfügbar waren. Als Beispiel nennt er den Einsatz im Freien, im Straßenverkehr, unter der Dusche oder in dringenden Situationen. „Jetzt können Gespräche leichter stattfinden, wenn zuvor Stille herrschte, und ich freue mich darauf, einige davon zu hören“, so Cave.

Weitere Artikel auf NextPit:

Quelle: Google, Google Start with One

Perfekt für die Nutzung mit Maske, fast so als wäre das geplant gewesen :P