Gegen Kindesmissbrauch: Warum Apple in den USA Nutzerfotos analysieren wird

Apple hat soeben neue Features gegen Bilder von Kindesmissbrauch angekündigt. Die Mitteilung folgte kurz nachdem die Financial Times die neuen Features enthüllt hatte. In den neusten Versionen von iOS, iPadOS, MacOS und watchOS werden Bilder, die Szenen von Kindesmissbrauch enthalten, in der iCloud markiert.

TL;DR

- Apples Nachrichten-App warnt zukünftig vor sexuell eindeutigen Inhalten

- Material mit Kindesmissbrauch wird in den iCloud-Fotos gekennzeichnet

- Siri und die Suche werden über zusätzliche Werkzeuge verfügen, um vor Kindesmissbrauch zu warnen

Die Financial Times veröffentlichte am Donnerstagnachmittag einen Artikel über neue Werkzeuge gegen Kindesmissbrauch in Apples Betriebssystemen. Kurz darauf bestätigte Apple die neuen Funktionen in einer offiziellen Pressemitteilung und in einem technischen Bericht.

Ab iOS 15, iPadOS 15, watchOS 8 und macOS Monterey – zunächst nur in den USA – werden aktualisierte Geräte über zusätzliche Funktionen verfügen, die die Verbreitung von Inhalten mit Kindesmissbrauch verhindern und davor warnen sollen.

Warnmeldungen für Eltern und Erziehungsberechtigte

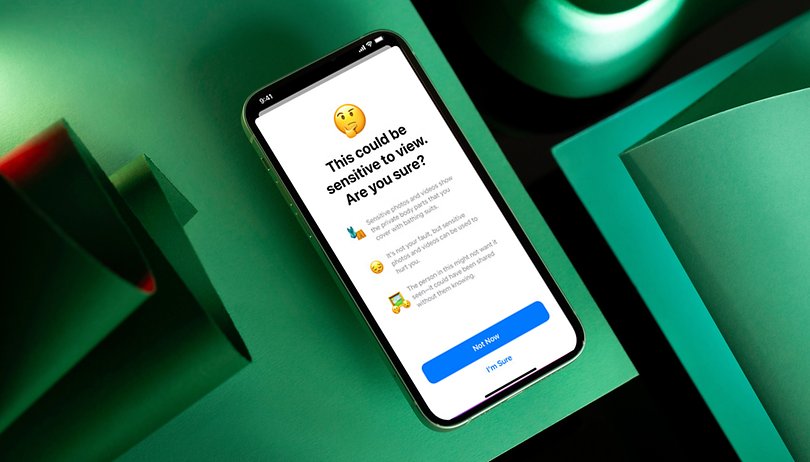

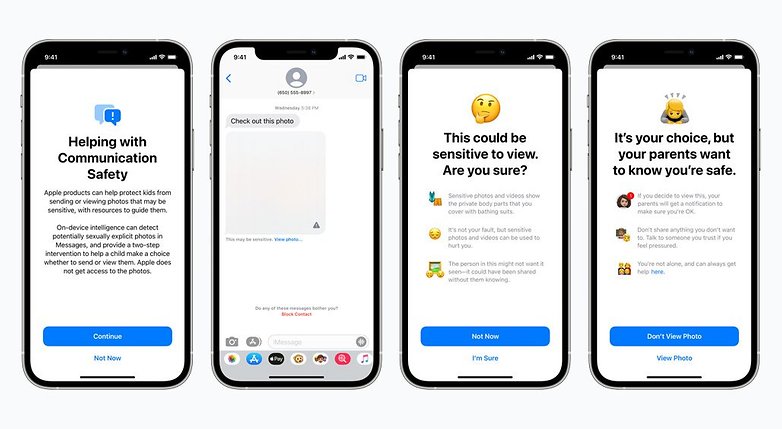

Die Nachrichten-App erkennt dabei den Versand und dem Empfang von sexuell eindeutigen Bildern. Diese werden dann über einen Unschärfeeffekt zunächst unkenntlich gemacht. Um eine derartige Nachricht zu sehen, müsst Ihr als Nutzer:in erst eine Warnung in Kenntnis nehmen und einen Dialog bestätigen.

Eltern oder Erziehungsberechtigte haben außerdem die Möglichkeit, sich benachrichtigen zu lassen, wenn ihr Kind Inhalte ansieht, die von Messages geflaggt wurden. Laut Apple wird die Analyse auf dem Gerät selbst durchgeführt, ohne dass das Unternehmen Zugriff auf die Inhalte hat.

Die neue Funktion wird dafür in die neuen Familienkonto-Optionen in iOS 15, iPadOS 15 und macOS Monterey integriert.

Erkennung in iCloud-Fotos

Die Funktion, die allerdings die meiste Aufmerksamkeit auf sich ziehen dürfte, ist die von Apple angekündigte neue Technologie zur Erkennung von Bildern, die Szenen von Kindesmissbrauch enthalten. Diese wird in iCloud integriert und in der Lage sein, Bilder zu identifizieren, die vom NCMEC (National Center for Missing and Exploited Children) registriert wurden.

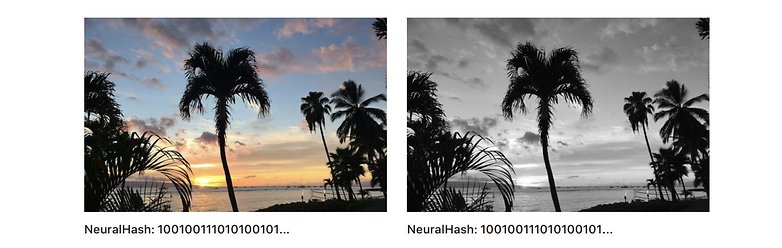

Obwohl das neue System die in der Cloud gespeicherten Dateien ausliest, funktioniert das System auf Grundlage eines Abgleichs der Daten auf dem Gerät selbst. Ein Anliegen, das von Apple mehrfach wiederholt wurde. Dazu wird lediglich ein Hash, also eine Kennung, verwendet und wischen den hochgeladenen Fotos und Bilder vom NCME sowie weiterer Organisationen abgeglichen.

Nach Angaben von Apple wird der Hash nicht verändert, wenn sich die Dateigröße ändert oder wenn Farben entfernt bzw. die Komprimierungsstufe des Bildes geändert wird. Das Unternehmen ist darüber hinaus nicht in der Lage, die Ergebnisse der Analyse zu interpretieren. Es sei denn, ein Konto überschreitet eine nicht weiter spezifizierte Grenze an positiven Identifizierungen.

Nach Angaben von Apple hat das System eine Fehlerrate von weniger als einer Billion pro Jahr. Bei der Identifizierung eines potenziell rechtsverletzenden Kontos wird eine Bewertung der analysierten Bilder vorgenommen. Sofern die Identifizierung bestätigt wird, schickt Apple nach der Deaktivierung des Kontos einen Bericht an die NCMEC. Dagegen können die Inhaber des Profils natürlich noch Einspruch erheben.

Schon vor der offiziellen Ankündigung des neuen Tools warnten Kryptographieexperten vor der Gefahr, dass Apples neues Feature die Tür für ähnliche Systeme zu anderen Zwecken öffnen könnte. Zum Beispiel zum Ausspionieren durch autoritäre Regierungen unter Umgehung der Schwierigkeiten, die durch Ende-zu-Ende-Verschlüsselungssysteme entstehen.

Bislang hat Apple noch nicht mitgeteilt, wann das System in anderen Regionen verfügbar sein wird und ob dies überhaupt geschieht. Wie sich das Ganze mit Datenschutzverordnungen wie der europäischen DSGVO vereinbaren lässt, ist ebenfalls noch offen.

Siri mischt sich auch ein

Das Paket der Neuerungen wird von Siri in Verbindung mit der Suche im Betriebssysteme abgeschlossen. Der Sprachassistent wird nun Informationen über Online-Sicherheit, einschließlich Links, anzeigen.

Wie bei den anderen Funktionen soll auch das zunächst nur in den Vereinigten Staaten angeboten werden. Auch hier ist wieder nicht absehbar, wann sie in anderen Regionen verfügbar sein wird.

Quelle: Apple

Ein weiterer Schritt in dem Algorithmen wieder etwas mehr Macht über uns übernehmen, getarnt unter einem Deckmantel.

War eine gute Idee von mir, Apple den Rücken zu kehren.

Warum? Hast was zu verstecken

Auch wenn man das nicht hat, möchte man nicht so gern unter Generalverdacht gestellt werden. Das wäre für mich auch Grund, keine Geräte dieses Herstellers zu kaufen.

Na klar hab ich.

Schöne neue Welt, wird man natürlich wie immer stillschweigend akzeptieren. Sind ja schließlich die guten, die so etwas machen. Wie groß wäre der Aufschrei,wenn es andere gemacht hätten. Ich finde, langsam geht das alles zu weit. Datenschutz gleich null. Streng genommen kann man diesen ganzen Mist mit dem Datenschutz auch weglassen, weil es nur in der Theorie nach Datenschutz klingt, in der Praxis aber nichts wert ist.

"Nach Angaben von Apple hat das System eine Fehlerrate von weniger als einer Billion pro Jahr."

Im Verhältnis zu wie vielen Bildern? 10 Billion? 100 Billion?

"Die Funktion, die allerdings die meiste Aufmerksamkeit auf sich ziehen dürfte, ist die von Apple angekündigte neue Technologie zur Erkennung von Bildern, die Szenen von Kindesmissbrauch enthalten. Diese wird in iCloud integriert und in der Lage sein, Bilder zu identifizieren, die vom NCMEC (National Center for Missing and Exploited Children) registriert wurden."

Die Technologie dahinter nennt sich PhotoDNA und befindet sich seit mindestens 10 Jahren im Einsatz, entwickelt wurde das von Microsoft. Apple hat in der Vergangenheit mindestens schon einmal angekündigt, die selbe in iCloud zu implementieren.

Jetzt werden für iCloud freigegebene, in entsprechenden Datenbanken registrierte Bilder eben bereits Lokal vor dem Upload erfasst, um eine weitere Verbreitung zu unterbinden.

Je nachdem, kann auch so in falschen Verdacht geraten. Wenn schon mit Menschenverstand Dinge missinterpretiert werden können, wage ich zu bezweifeln, dass es eine KI (heute) besser kann.

Beispiel eines Missverständnisses trotz Menschenverstand: ein guter Freund war damals in einer Innenstadt unterwegs, wo auch ein recht spontaner Nazi-Aufmarsch war. Ein Bild tauchte in der örtlichen Zeitung auf, auf dem man ihn gut erkannte und es so aussah, als liefe er mit. In diesem Sekundenbruchteil hat einfach alles gestimmt: Blickrichtung, Laufrichtung usw. Da er Beamtenanwärter war, zitierte ihn sein Vorgesetzter in sein Büro und er wies ihn darauf hin, dass es mit dem Beamtentum wohl nichts wird und er sich eine andere Stelle suchen möge, bevor disziplinarische Maßnahmen greifen würden. Nach mehrfacher Beteuerung, dass er mit den Rechten nix zu tun hat und nur durch Zufall genau zu dem Zeitpunkt da war, glaubte er ihm. Wäre hier eine KI besser gewesen? Ich denke nicht. Sie hätte ihm wohl den Stempel Neonazi verpasst. Und wer weiß, wohin diese Information überall wäre gespeichert worden. Das Netz vergisst ja schließlich nichts.

So Löblich der Grundgedanke auch ist.

Ja wo hört es mal auf...

Mir gefielen meine Nokia Smartohones die auch noch gute offline Geräte waren und die Internetverbindung nur bei Bedarf benutzten.

Wir werden alles bis auf das grausamste immer mehr durchleuchtet und ausgewertet.

Noch ein Grund kein Apple zu nutzen. Bilder zu analysieren kann m.E. mit nichts gerechtfertigt werden.

Würde mich nicht wundern, wenn in spätestens ein paar Wochen von Google eine Meldung kommt, dass sie genau das gleiche machen werden.

Zudem werden Bilder von allen Geräten doch schon seit Jahren analysiert, um sie zu optimieren etc.

Das habe ich bei mir noch nicht bemerkt. Würde auffallen wenn Google Bilder ins Netz überträgt um sie zu analysieren, und es es wäre erschreckend wenn Google Daten aus dem Arbeitsbereich (Samsung Knox, "Sichere Ordner") abziehen könnte. Ich nutze die Cloud nicht.

Machen Google und Microsoft schon.

Quelle: blog.google/outreach-initiatives/google-org/our-continued-commitment-to-combating/

Die Samsung Bildergallerie wird optional auch durch gescannt. Man kann ha selbst suchen nach speziellen leuten, autos u.s.w

So werden einem ja auch die collagen vorgeschlagen, ich habe diese option aus mag es nicht wenn meine Bilder so gescannt werden und ob man das immer glauben kann das es anonymisiert nur von Algorithmen gemacht wird, möchte ich allgemein mal anzweifeln.

Ja Rene hast du denn in der Samsung Gallerie auch alle Optionen zur Bildsuche, Colagen Vorschläge u.s.w auch aus?

In der Cloud machen das Apple, Google und Microsoft schon länger. Es hat schon seine Gründe, dass ich deren Cloudspeicher nicht nutze.

Neu ist neben der lokalen Suche die Meldung an die NCMEC.

Ich habe heute morgen an anderer Stelle davon gelesen und es haben sich meine Nackenhaare aufgestellt. Auf den ersten Blick kann man das nur unterstützen, sofern man nicht selbst pädofil ist. Aber bei genauerem Nachdenken: Wer sagt, dass es dabei bleibt? Was, wenn man fälschlicherweise beschuldigt wird? Es kennst wohl so ziemlich jeder die Aussage "Steht aber im Computer" und ein "Dann hat das jemand falsch erfasst." wird mit "Steht aber so im Computer" beantwortet.

Wenn das ein Algorithmus erfasst hat, ist noch nicht einmal jemand schuld. Die KI hat immer Recht. Oder?

Aries

Genau das hatte ich auch geschrieben. Ich mache grundsätzlich nur Bilder (wenn sie mal nackt rumspringt) von meiner Tochter wo ihr Intimsbreich nicht sichtbar ist. Beim Baden lege ich zum Beispiel einen Waschlappen drüber. Wenn ich jetzt ein Bild mache wo ich den Waschlappen gerade anfasse und es über ihrem Schambereich ist, werde ich dann auch markiert?

-

Admin

06.08.2021 Link zum KommentarDie Bilder zu machen ist ja nicht das Problem, sondern sie zu verschicken.

C.F

„ Obwohl das neue System die in der Cloud gespeicherten Dateien ausliest, funktioniert das System auf Grundlage eines Abgleichs der Daten auf dem Gerät selbst“

„ Erkennung in iCloud-Fotos“

Ich lese das so dass das auch dann passiert wenn ich die Bilder machen da diese ja in die iCloud hochgeladen werden