Machine Learning und KI: So werden Smartphones immer schlauer

Künstliche Intelligenz (KI), Artificial Intelligence (AI) oder Machine Learning (ML): Diese Stichworte fallen inzwischen auf jeder Präsentation eines neuen Smartphones und sind wohl der große Trend der Jahre 2017/18. Einige Smartphones besitzen gar einen eigenen AI-Chip, der die Smartphones besonders smart machen soll, so die Hersteller. Aber was ist an den Slogans eigentlich belastbar? Wir beleuchten die Anwendungsfelder und Chips einmal genauer, um Fakten von Fiktion zu trennen.

Als Huawei zur IFA 2017 mit dem Kirin 970 von Tochterfirma Hisilicon den ersten Smartphone-Prozessor mit einer KI-Einheit vorstellte, hatten die Chinesen die Aufmerksamkeit der Öffentlichkeit erobert. Die Neural Processing Unit (NPU) ist auf dem SoC eigens für die Funktionen zuständig, die mit KI schneller und besser zu erledigen sind als mit einem traditionellen Prozessor. Dazu gehören derzeit vor allem Aspekte, die mit Fotografie, Bilderkennung und -verarbeitung zu tun haben.

Seit der IFA 2018 gibt es bereits den Nachfolger Kirin 980, und der hat nicht nur eine, sondern gleich zwei NPU-Einheiten zu bieten. Damit dreht Huawei vor allem die Performance nach oben, denn wirklich neue Funktionen bekommt der Chip durch die zweite KI-Einheit nicht. Dafür steigt die Geschwindigkeit massiv, während der Energieverbrauch unter dem Strich sinkt - clever.

Der Begriff KI geht zu weit

Künstliche Intelligenz ist zunächst einmal der falsche Begriff: Kernpunkt aller heutigen sogenannten KI-Anwendungen im Endkundenbereich ist tatsächlich Machine Learning. Ein sogenanntes Convolutional Neural Network (CNN) lernt anhand einer großen Menge Rohdaten, Muster zu erkennen – und zwar ganz selbstständig. Dieses Training findet üblicherweise auf großen Serverfarmen statt, denn es erfordert eine immense Menge an Daten. Eine Machine-Learning-Anwendung kann nun die im ersten Schritt trainierten bzw. gelernten Muster auf weitere Daten anwenden – dieser Schritt wird auch mit dem Fachbegriff Inferenz beschrieben. Für Smartphones ist zunächst einmal vor allem der letztere Schritt relevant. Ein trainiertes neurales Netz kann auf einem Bild zum Beispiel Objekte oder Gesichter erkennen.

Generell sind die dabei anfallenden Berechnungen natürlich auch mit der klassischen CPU möglich. Die einzelnen Rechenoperationen sind zwar eher simpel, aber so zahlreich, dass sie auch einen Octa-Core-Prozessor enorm fordern. Mehr Kerne sind also der Schlüssel zum Erfolg, und die müssen gar nicht so viel können. Ein Chip mit sehr vielen (kleinen) Rechenwerken kann Machine-Learning-Anwendungen daher effizienter ausführen als ein Standard-Prozessor.

Die Grafik-Chips sind wie gemacht für Machine Learning

Wo findet man diese vielen Kerne? Richtig, im Grafikchip, also der GPU. Die ist natürlich selbst im Smartphone-Alltag auch durch Standardaufgaben belastet. Deshalb sind NPU-Einheiten ähnlich aufgebaut wie eine zusätzliche GPU: Enorm viele Rechenkerne bearbeiten die zahlreichen Operationen parallel, was zu großen Leistungsvorteilen bei Machine-Learning-Anwendungen führt.

Und warum braucht man das überhaupt auf einem Smartphone? Diese Berechnungen könnte man doch auch auf den großen, leistungsfähigen Servern im Rechenzentrum ausführen und die Daten dann über die Cloud austauschen. Klar, könnte man. Doch die Cloud hat bekannte Nachteile, die auch für Machine Learning gelten: Sie ist nur bei einer stabilen Internetverbindung zuverlässig nutzbar und die Datenübertragung würde schnell zu untragbaren Verzögerungen führen. Beispielsweise müsste die Kamera-App ständig Vorschaubilder auf Server laden, um den Bildinhalt zu erkennen. Und das zeigt einen weiteren massiven Nachteil: User sind möglicherweise skeptisch in puncto Datenschutz. On-Device-Machine-Learning ist für viele Anwendungen daher ohne Alternative.

Was machen aktuelle Smartphones mit dem Chip?

Aktuell gibt es mehrere Smartphones, die bereits über eine NPU verfügen, und sie werden mehr. Neben den Huawei- und Honor-Flaggschiffen sind es vor allem die aktuellen iPhones, die einen Prozessor mit dedizierter NPU besitzen, den Apple A12 Bionic und dessen Vorgänger, den Apple A11. In vielen aktuellen Qualcomm-Chipsätzen, welche die meisten Smartphones antreiben, kommt das sogenannte heterogene Computing zum Einsatz.

Damit ist es möglich, dass eine Aufgabe auf den jeweils besten Chip im Smartphone ausgeführt wird. Davon gibt es eine Menge: Die klassische CPU, die GPU und den Signalprozessor. All diese Rechenwerke haben unterschiedliche Stärken. Die CPU punktet vor allem bei komplizierten Berechnungen, die nicht nebeneinander ausgeführt werden können, die GPU hingegen kann Berechnungen beschleunigen, die gleichzeitig stattfinden dürfen. Und der Signalprozessor ist auf Echtzeitberechnungen optimiert. Machine-Learning-Anwendungen können so stets vom besten Rechenwerk bearbeitet werden.

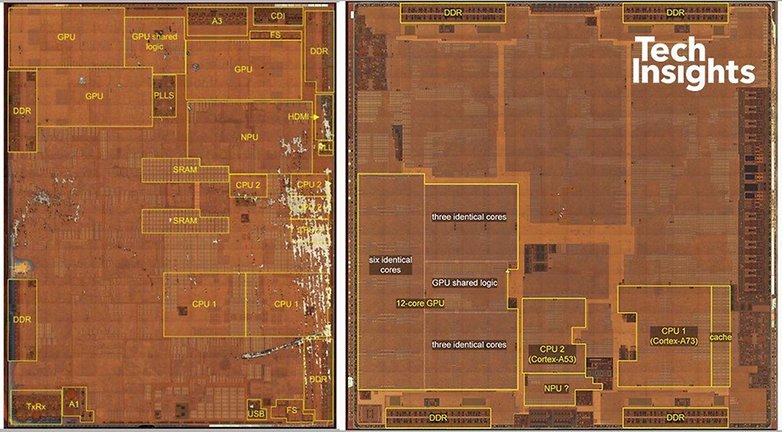

Kurz nach den ersten KI-Prozessoren von Huawei-Tochter Hisiicon präsentierte Apple im Vorjahr den Chip A11 – natürlich mit NPU. 2018 folgte der A12 Bionic mit ähnlichen Verbesserungen wie beim Sprung von Kirin 970 zu 980 - mehr Transistoren, mehr Leistung, weniger Stromhunger. Die NPU kommt zum Beispiel bei FaceID, der Entsperrung mit dem Gesicht, zum Einsatz. Zudem nutzt Apple die KI-Power für Augmented-Reality-Anwendungen, Smart HDR, Spiele und mehr. Mit acht Kernen schafft die KI-Einheit im A12 Bionic unglaubliche 5 Billionen Berechnungen pro Sekunde. Im obigen Bild zeigt sich, dass die NPU im Kirin 970 recht klein ausfällt (unten mittig), während Apple einen recht großen Teil des Chips für die NPU reserviert (oben rechts).

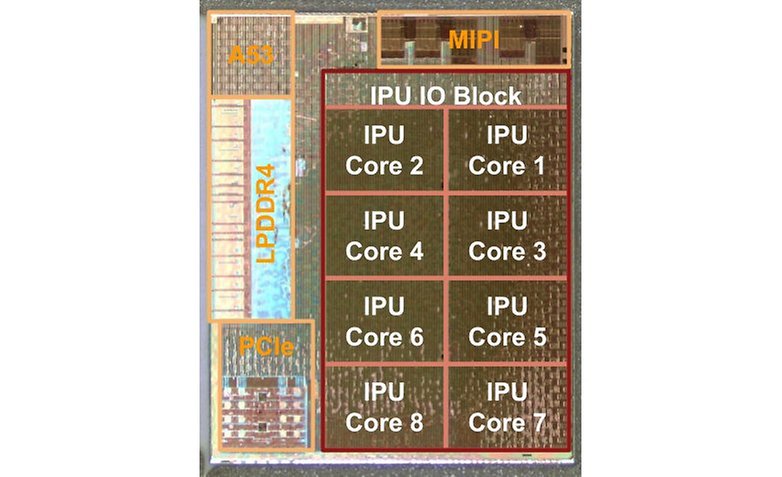

Im Google Pixel 3 (XL) wiederum steckt wie schon im Pixel 2 (XL) der Pixel Visual Core. Der Visual Core ist eine klassische NPU, allerdings mit einer wechselhaften Geschichte. Zunächst lag der Chip brach, erst Android 8.1 aktivierte ihn. Aber nur, damit Drittanbieter-Apps HDR+ verwenden können. Die Standard-Kamera-App verwendet den Visual Core erst mit der neuesten Version, beim Pixel 2 (XL) ging das zunächst nicht.

Ab Android 8.1 existiert die Schnittstelle Neural Networks API (NN-API), mit der App-Entwickler auf NPUs zugreifen können, ohne die technischen Spezifika der jeweiligen Implementierung zu kennen. Als Fallback kommt gar die CPU zum Einsatz, falls im Smartphone keine NPU verbaut ist. Bis dahin ist der Zugriff nur über herstellerspezifische Routinen möglich. Im Pixel existiert tatsächlich nur der Weg über die NN-API. Google hat eine abstrakte Bibliothek vorgestellt, die das NN-API komplett unterstützt: Tensorflow Lite. Diese Bibliothek erlaubt es, trainierte neurale Netze auf Smartphones einzusetzen. Sie könnte schon bald Standard in vielen Android-Apps werden.

Huawei setzt Machine Learning für vier Features ein

In den aktuellen Top-Smartphones Smartphones wie dem Huawei Mate 20 Pro macht sich der chinesische Hersteller vor allem an vier Stellen die NPU zunutze. Der erste und für die Anwender sichtbarste Punkt ist die Motiverkennung beim Fotografieren, die die Kameraparameter dem Motiv vor der Linse anpasst. Ein kleines Symbol in der App zeigt an, was die Kamera-App dank Machine Learning vor der Kamera erkannt hat.

Zweitens nutzt Huawei die NPU im Kirin 980 (und auch immer noch im 970, etwa im P20 Pro), um das Nutzungsverhalten des Anwenders besser verstehen und vorhersagen zu können. So lassen sich die Ressourcen besser einteilen und die Energieeffizienz verbessern – zumindest auf dem Papier. Solche Versprechen sind vom Hersteller zwar schnell gegeben, lassen sich jedoch kaum stichhaltig überprüfen, denn dazu bräuchte es zwei Testgeräte, eines davon ohne oder mit deaktivierter NPU.

Der dritte Einsatzzweck ist einer Kooperation mit Microsoft entsprungen. Die Übersetzungs-App von Microsoft, die auf den Smartphones vorinstalliert ist, nutzt die NPU für schnellere Übersetzungen, die prinzipiell auch offline funktionieren.

Es hat sich außerdem gezeigt, dass CNNs besonders gut zur Rauschreduzierung von Audiosignalen geeignet sind. So kann ein trainiertes neurales Netzwerk zum Beispiel in lauten Umgebungen als Rauschfilter dienen und damit die Erkennung von Sprachbefehlen erhöhen. Hisilicon sagt, die Erkennungssicherheit könne in schwierigen Umgebungen von 80 auf 92 Prozent gesteigert werden. Die nötigen Berechnungen sind nur von einer NPU sinnvoll zu stemmen – Einsatzzweck Nummer Vier.

Die AI-Chips im Leistungsvergleich

Einige erhältliche Smartphones haben also bereits eine Neural Processing Unit an Bord, potenziell viele weitere durch Qualcomms Ansatz des heterogenen Computings. Da fragt man sich schnell: Welche NPU ist nun schneller? Das geht gewissermaßen mit der Frage einher, welche NPU den geringeren Stromverbrauch aufweist – bei gleicher Aufgabe natürlich. Hier müssen wir uns noch auf die Daten der ersten KI-Generation aus dem Jahr 2017 stützen, denn Kirin 980 und Apple A12 Bionic wurden in den Laboren noch nicht verglichen. Deren Erkenntnisse zeigen aber einen Vorteil in der Architektur mit separater NPU, der auch bei den aktuellen Chips gültig ist.

Aufgrund der Eigenarten von NPUs sind die Fragen nach der Leistungsfähigkeit gar nicht so einfach zu beantworten. Immerhin gibt es erste Hinweise, die anhand der chinesischen Benchmark-Suite Master Lu entstanden sind. Anandtech hat ein Mate 10 Pro, ein Google Pixel 2 XL sowie ein LG V30 getestet.

Im Mate 10 Pro kam die NPU ganz regulär zum Einsatz und das LG V30 konnte das heterogene Computing auf einem Snapdragon 835 vollführen. Das Pixel 2 XL hingegen unterstützt die Qualcomm-Technologie nicht, der Benchmark wiederum nicht die NN-API. Das Pixel 2 liefert daher Werte für rein CPU-gestützte Machine-Learning-Anwendungen.

Und die fällt nicht gut aus. Master Lu gibt Werte in Frames pro Sekunde aus. Während das Pixel 2 mit der CPU im ersten Test 0,7 Bilder pro Sekunde verarbeitet, kommt das LG V30 mit Qualcomms heterogenen Computing auf immerhin 5,3 fps. Das Mate 10 Pro mit NPU schafft 15,1 fps. Die NPU und Qualcomms Ansatz kommen beim Stromverbrauch auf ähnliche Werte: Das Mate 10 Pro benötigt pro Inferenz 106 Milli-Joule (mJ), das V30 etwas mehr mit 130 mJ. Das Pixel ohne Machine-Learning-Beschleunigung verbaucht 5.847 mJ – alle drei Werte laut den Messungen von Anandtech. Wer sich für die weiteren technischen Details interessiert, schaut einmal bei Anandtech vorbei.

Weitere Tests von Anandtech zeigen ebenso das beeindruckende Resultat: Die Anwendung von neuralen Netzen auf Bilder erfolgt mit den spezialisierten Chips einerseits viel schneller, andererseits auch noch erheblich stromsparender.

Für unseren Zusammenhang zeigt sich, dass die spezialisierten Rechenwerke für Machine Learning einen riesigen Unterschied machen, sobald sie zum Einsatz kommen. Bilderkennung, Rauschreduzierung, verbesserte Stimmenerkennung: All das sind Anwendungen, die potenziell von einer NPU profitieren. Obwohl Qualcomms Ansatz der NPU des Kirin 970 unterlegen ist, dürfte sich das mit dem Snapdragon 845 verändern: Dessen Signalprozessor soll rund dreimal schneller agieren und damit zur NPU von Huawei aufschließen.

NPU im Smartphone - brauche ich das?

Machen wir uns nichts vor: Auf dem Stand, auf dem die Anwendungen von Machine Learning derzeit sind, kann man noch sehr gut ohne sie leben. Die Funktionen, bei denen sich die Leistungsfähigkeit einer NPU oder spezielle Anpassungen wie bei den neuen Snapdragon-Prozessoren tatsächlich bemerkbar machen, sind zwar wichtig, aber noch recht überschaubar.

Das kann sich aber schneller ändern, als man denkt, denn alle diese Funktionen sind nichts als Software. Die lässt sich problemlos als Update auf eben die Smartphones verteilen, die in Sachen Hardware bereits entsprechend ausgestattet sind. App-Entwickler können bald mittels NN-API und Tensorflow Lite auf NPU-artige Rechenwerke zugreifen. Wer also schon heute ein Smartphone mit NPU - egal ob eine oder mehrere - besitzt, dürfte zu den ersten gehören, die diese neuen Funktionen einsetzen können – der Traum eines Early Adopters also.

Wie steht Ihr zu Machine Learning auf dem Smartphone? Achtet Ihr schon auf eine NPU? Oder sind Machine-Learning-Features für Euch nicht wichtig? Lasst uns in den Kommentaren diskutieren.

Dieser Artikel wurde am 31.10.2018 umfassend aktualisiert.

Quelle: Anandtech, TechInsights, TechInsights

Das eine KI lernt muss such sein. Nur Emotionen empfinden wird schwer.

2 Augen sehen nicht so viel wie eine fühlende Hand:

Sehr interessanter Artikel, vielen Dank für die gutverständliche Aufbereitung des Themas.

Cool 😅✌die KI lernt immer mehr und bald werden die Smartphones uns assimilieren wie die Borg und gehörst du nicht dann terminiert.☹

KI auf 'nem Handy ist zur Zeit ohne belang. Die Software soll nur ausbügeln was in Sachen Hardware mangelhaft ist. In Sachen Kamera werden die Gegebenheiten der kleinen Brennweite, Tiefenschärfe ( Blende) und winzige Pixel sprich Isolierung zwischen den Pixeln versucht rauszugehen. Geschuldet eben der geringen Bautiefe. Alles andere sind nur simple Programmroutinen. Wenn man wirklich das I braucht, lautet die Devise, Informationsbeschaffung und nachdenken.

Der KI-Shit kommt unaufhaltsam - wenn wir den Scheiß, der uns aufoktruiert werden soll, kaufen/bezahlen. - Schaltet mal lieber öfter das Hirn sowie die soziale Intelligenz ein und das "Smartphone" aus. - Lest mal lieber ein analoges Buch statt ein eBook, das Euer Leseverhalten auswertet und damit Euch AUCH noch analysiert. Ich war ja immer ein Tech-Freak - aber der unbedarfte Umgang von der Mehrheit der "Zeitgenossen", die ihr permanentes SP-Gedaddle einem intensiven persönlichen Dialog vorziehen, geht mir langsam über die Hutschnur. - Stets & immer beschäftigt + nichts begriffen.

So muss es ja nicht sein. Egal was man im Leben macht, die Selbstständigkeit sollte man schon behalten. Außer man kann aus verschiedenen Gründen einer Beeinträchtigung nicht mehr so gut. Ein Smartphone erleichtert uns im Alltag schon sehr viel. Man braucht keine analoge Landkarte mehr dank Google Maps, Wikipedia hat man immer und jederzeit bei sich, bei Youtube kann man sich Anleitungen zu jedem Thema anschauen... Technik soll uns Dinge im Alltag erleichtern und schneller zugänglich machen. Deshalb muss man nicht gleich verblöden.. Man verliert ja auch nicht seine Sportlichkeit wenn man den Aufzug anstatt der Treppe nimmt oder?

Mal angenommen, es kommt ein Netzwerksausfall/Hack (gar nicht so selten) oder ein totaler Stromausfall (eher selten; nicht unwahrscheinlich)? - Dann "guckst Du" in die Röhre? - Genau an der Technologieschwelle werden die meisten Tech-Freaks bemerken, dass man mit Plastikkarte in einem Shop mit elektrischen Türen/Kassen "nichts zu fressen" bekommt. - Ich möchte das nicht weiter ausführen.

Das ist ja schon lange bekannt das die Technik umso mehr sie ausgefeilt ist auch viel anfälliger für Störungen und Probleme ist. Das hab ich schon in den 90er Jahren mitbekommen, als Autos und Motorräder mit jeder Menge Technik vollgestopft wurden, aber andauernd wegen irgendwelchen Defekten in die Werkstatt mußten. Technik ist nur solange gut, solange sie funktioniert. Gegen einen Stromausfall (wahrscheinlich hatte den jeder schon mal miterlebt) kann man sich mit einem Notstromgenerator behelfen, so wie das auch in einem Krankenhaus ist und sein muss. Und gegen defekte Plastikkarten und Lesegeräte hilft immer wenn man auch zusätzlich etwas Bargeld bei sich hat. Genau diese Beispiele zeigen das man hier schon sein Hirn einschalten kann wenn man zwar Technik nutzt, aber trotzdem einen Plan B hat.

Mach doch mal den Versuch und nimm mal jungen Menschen (14-18) ihr geliebtes Smartphone weg, und schaue was passiert.

Wahrscheinlich das kommt das selbe raus, wenn man älteren Menschen (18- 70) ihr geliebtes Auto wegnehmen würde.

Denke nicht. Denn ich habe schon beobachtet wie es so ist. Bei jedem zweiten Problem versucht man erst einmal im Internet eine Lösung zu finden bevor man nachdenkt.

Solange man überhaupt eine Lösung findet ist das völlig ok so. Wichtig ist das man weiß was man sucht und wenn man eine Lösung gefunden hat, diese dann auch als richtig erkennt und auch richtig anwendet. Umgekehrt hab ich aber auch schon erlebt das Leute nach einer Lösung verzweifelt suchen, aber ganz vergessen das sie Internet haben.

Was ist aber dann, wenn man als erstes immer nur zum Internet greift, dann aber von der einen zur anderen Minute das nicht mehr hat? Und das denken vollständig verlernt hat (sorry den Verdacht habe ich so manches mal)?

Das erinnert mich an meine Schulzeit. Wir durften zeitweise einen Taschenrechner verwenden um entweder das Ergebnis nachzuprüfen oder einfach als Hilfestellung. Trotzdem mußten wir die meiste Zeit selbst Rechnen. Die Idee von unserem Lehrer war, das man ja trotzdem wissen muss wie man bei einer mathematischen Formel auf das Ergebnis kommt. Der Taschenrechner gibt nur das raus was man eingibt.

Genau das meinte ich, aber leider sieht das in der heutigen Zeit anders aus. Es gibt leider schon zu viele jung (aber auch ältere Menschen) die das denken vollständig eingestellt haben (o.k. das war eventuell etwas überspitzt). Mann macht sich keine eigenen Gedanken mehr, man glaubt alles was die bunte WWW Welt einem vorgaukelt, und dann noch KI? die dann noch den Rest vom Gehirn übernehmen soll? Und der ja so "intelligente" Verbraucher glaubt das auch noch. Was soll aus der Menschheit werden? Einer macht vor und alle anderen (weil wenn es keinen schadet) laufen hinterher?

Denken und eigene Entscheidungen treffen, Dinge hinterfragen? Leider Fehlanzeige.

Wie leicht ist es dann die Meinung der Menschen zu manipulieren?

@Peter

Dem stimme ich absolut zu. Klar bringt der unbedachte Umgang mit Smartphone und co Probleme mit sich, sie bieten aber auch den Zugang zur Lösung vieler Probleme. Sei es eine Anleitung um etwas zu reparieren oder einzustellen, zu übersetzen, seine Steuererklärung richtig auszufüllen oder sonstwie zu informieren.

Ist das selbe Thema wie früher beim Fernsehen, da hieß es auch immer "Fernsehen macht dumm". Aber natürlich ist entscheidend was man schaut, Lindenstraße (und/oder Nachfolger) oder informative Dokumentationen.

Das eigentliche Problem ist, wie der "richtige" Umgang erlernt werden soll. Vor allem da nicht mal Einigkeit herrscht, was denn richtig ist.

KI ist genau so ein Begriff wie randloses Display, beides ist einfach nicht richtig. Für künstliche Intelligenz braucht es mehr genauso wie dünne Balken ums Display nicht randlos ist. Der Begriff "Machine Learning" kann man gerne verwenden, aber KI oder AI sind nur Blendbegriffe, die heute im hier und jetzt aus der Sci-Fi entliehen sind. Und eigentlich nutzen die Hersteller all die Begriffe aus Werbegründen um die höhren Preise zu rechtfertigen. Eine echte Neuheit mit Mehrwert wäre zur Abwechslung mal nicht schlecht.

Wirklich guter und offener Artikel.

Wie bei allen großen Neuerungen wird es eine bestimmte Zeit brauchen, bis der Nutzen auch den "Durchschnittsanwender" erreicht. Vor Allem bei uns!

Aber gerade hinsichtlich genau dieses Themas, hilft diese Entwicklung sich selbst zur Weiterentwicklung.

Das bedeutet, dass der allgemeine Nutzen doch ab einem bestimmten Punkt sehr plötzlich verfügbar und begehrenswert sein wird.

Das wird noch ne ganz heiße Nummer. Und zwar bei allen Geräten, die eine Ein- bzw. Ausgabe, oder in jeglicher Art und Weise Steuerungsfunktionen haben . Das ist sicher!

Meine ehrliche Meinung zu diesem Thema ist wie folgt.

- derzeit ist es nur Marketing um die Kunden zu ködern sich neue Geräte zu kaufen.

- eine KI benötigt Unmengen an Daten um richtig arbeiten zu können daher ist das lokal kaum zu machen

- was jetzt so als KI vermarktet wird, wie z.B. von Huawei ist ein Prozessor welcher für bestimmte Aufgaben entwickelt wurde und z.B. bei der Kamera Unterstützung liefert .

Ein Test aus China der einen Hersteller aus 🇨🇳 bevorzugt und das alles glauben wir jetzt auch. Fake news! War nur Spaß 😂